IA en 2026 : après l’illusion des modèles, le retour à l’infrastructure et aux systèmes

par Jérémy Guillier, Consultant en financement de l’innovation chez EPSA. Jérémy est consultant en financement de l’innovation chez EPSA, spécialisé sur les enjeux liés au numérique et aux NTIC. Il accompagne des entreprises innovantes dans la structuration, la valorisation et le financement de leurs projets de R&D (CIR/CII), avec un intérêt particulier pour les architectures technologiques émergentes, les systèmes complexes et les transformations numériques à fort impact business.

Sortir enfin de la confusion

Les années 2023 à 2025 auront été marquées par une accélération spectaculaire de l’intelligence artificielle, portée presque exclusivement par la montée en puissance des modèles de langage (GPT-4/4o et leurs successeurs chez OpenAI, Claude chez Anthropic, Gemini chez Google, LLaMA puis ses dérivés open-weight, ou encore des modèles émergents comme DeepSeek). Pour beaucoup d’organisations, l’IA est alors devenue synonyme de LLM, de chatbots, d’agents conversationnels et de promesses de transformation rapide.

Cette période a été nécessaire. Elle a permis de démocratiser l’IA, de révéler son potentiel opérationnel et d’abaisser radicalement les barrières d’entrée.

Mais elle a aussi entretenu une confusion durable entre performance linguistique et intelligence au sens fort, entre capacité à produire du langage et capacité à comprendre, prédire et agir dans le monde réel.

Développez l’utilisation de l’IA avec nos experts

Bilan 2023-2025 : ce que les LLM ont réellement apporté

Les modèles de langage ont profondément transformé l’interface entre l’humain et les systèmes numériques. Ils ont introduit une couche universelle de langage capable de traduire des intentions humaines en requêtes exploitables par des systèmes complexes.

Ils se sont révélés extrêmement efficaces pour synthétiser, reformuler, expliquer, documenter, coder, classer, explorer.

Dans les entreprises, leur impact est tangible : accélération des tâches cognitives, fluidification de l’accès à l’information, réduction du coût de certaines activités intellectuelles, amélioration de la productivité individuelle.

Sur ce plan, le bilan est clairement positif.

Mais cette montée en puissance a aussi mis en lumière leurs limites fondamentales. Un LLM ne comprend pas le monde qu’il décrit. Il ne dispose ni de modèle physique, ni de représentation causale, ni de capacité intrinsèque à anticiper des états futurs. Il excelle dans la forme, pas dans la dynamique. Il produit des raisonnements plausibles, mais pas des décisions optimisées. Il imite la pensée sans en posséder les mécanismes profonds.

Cette distinction, longtemps théorique, est devenue concrète dès lors que les entreprises ont tenté de confier aux modèles des tâches complexes, critiques ou autonomes. Les erreurs, incohérences et fragilités observées ne relèvent pas de bugs passagers, mais de limites structurelles.

« L’agentification » : un progrès… qui confirme les limites

La montée des architectures agentiques est souvent présentée comme l’étape suivante vers une IA plus autonome. En réalité, elle constitue surtout une reconnaissance implicite des limites des LLM.

Les systèmes dits “agents” ne rendent pas les modèles plus intelligents. Ils déplacent le raisonnement hors du modèle. La planification, la décomposition des tâches, la vérification, l’exploration et l’orchestration sont externalisées vers des couches supplémentaires : moteurs de règles, workflows, boucles de contrôle, appels d’outils, supervision humaine.

Le modèle de langage reste volontairement cantonné à ce qu’il sait bien faire : comprendre une intention, reformuler une tâche, produire du langage, guider l’exécution.

L’intelligence globale du système ne réside plus dans un modèle unique, mais dans l’architecture qui coordonne l’ensemble.

De ce point de vue, l’agentification ne mène pas vers une intelligence générale. Elle marque au contraire le passage d’un imaginaire cognitif à une logique d’ingénierie des systèmes intelligents, où la fiabilité prime sur l’illusion d’autonomie.

Tirez le meilleur de l’IA pour développer vos projets avec nos experts

La fin des récits dominants : ni course à l’AGI (intelligence artificielle générale), ni capture totale

En parallèle, un autre glissement s’opère dans la manière de parler de l’IA. Deux récits ont longtemps structuré le débat public : celui de la course géopolitique (États-Unis contre Chine, souveraineté européenne) et celui de la concentration corporate (quelques géants capturant l’ensemble de la valeur).

Ces récits reposent sur une même hypothèse implicite : l’IA serait un actif que l’on peut posséder, capturer ou verrouiller. Or l’observation fine de l’infrastructure réelle de l’IA invalide cette vision.

Les puces sont conçues par certains acteurs, fabriquées par d’autres, avec des dépendances critiques à des chaînes d’approvisionnement non nationales. Le capital est transnational. Les talents circulent. Les données sont mondiales. Les modèles eux-mêmes franchissent plus facilement les frontières qu’on ne le croit.

Ni les États ni les entreprises ne contrôlent entièrement cette infrastructure. Ils peuvent l’influencer, la perturber, la ralentir, mais pas la refermer.

Cette réalité conduit à un changement de perspective majeur : l’IA ne se joue pas uniquement dans les centres de pouvoir visibles, mais dans les interstices !

Ces interstices ne sont pas des zones marginales ou résiduelles. Ils constituent au contraire les espaces où se construisent, de manière pragmatique, les usages réels de l’IA. C’est là que s’opèrent les arbitrages entre dépendance et autonomie, standardisation et différenciation, puissance brute et efficacité opérationnelle. Les interstices sont les lieux où l’on ne cherche pas à “gagner la course”, mais à rendre l’IA déployable, soutenable et compatible avec des contraintes économiques, réglementaires et énergétiques concrètes.

Ils apparaissent notamment au niveau applicatif, là où la majorité de la valeur est effectivement créée : dans la manière dont les modèles sont intégrés aux systèmes existants, combinés à des données locales, encadrés par des règles métier, et orchestrés au sein de chaînes de décision plus larges. À cet endroit, la frontière entre acteur dominant et acteur dépendant devient plus poreuse, et la capacité à concevoir des architectures hybrides, évolutives et réversibles devient un avantage stratégique décisif.

Autrement dit, si l’entraînement des modèles de frontière reste concentré et coûteux, le déploiement, l’assemblage et l’usage de l’IA restent largement ouverts. C’est dans cet écart, entre ce qui est difficilement capturable et ce qui reste malléable, que se situent aujourd’hui les véritables marges de manœuvre, pour les entreprises comme pour les États.

2026 : l’IA comme système distribué et hybride

À l’aube de 2026, l’IA apparaît moins comme un modèle toujours plus grand que comme une architecture distribuée, composée de briques complémentaires. Les organisations les plus matures ne cherchent plus à “choisir le meilleur modèle”, mais à assembler des systèmes cohérents, maîtrisés et évolutifs.

Une IA opérationnelle repose désormais sur :

- des modèles de langage comme interfaces cognitives,

- des systèmes documentaires pour garantir la vérité et la traçabilité,

- des moteurs de règles pour assurer la conformité métier,

- des modèles prédictifs pour l’anticipation et la gestion des risques,

- des moteurs d’optimisation pour la décision,

- des agents encadrés pour l’exécution,

- et des humains comme superviseurs, arbitres et responsables ultimes.

Cette hybridation n’est pas un compromis. Elle est la condition d’une IA industrielle, fiable, auditable et soutenable.

Etre accompagné par un expert sur vos sujets IA

Ce que sera réellement l’IA en 2026

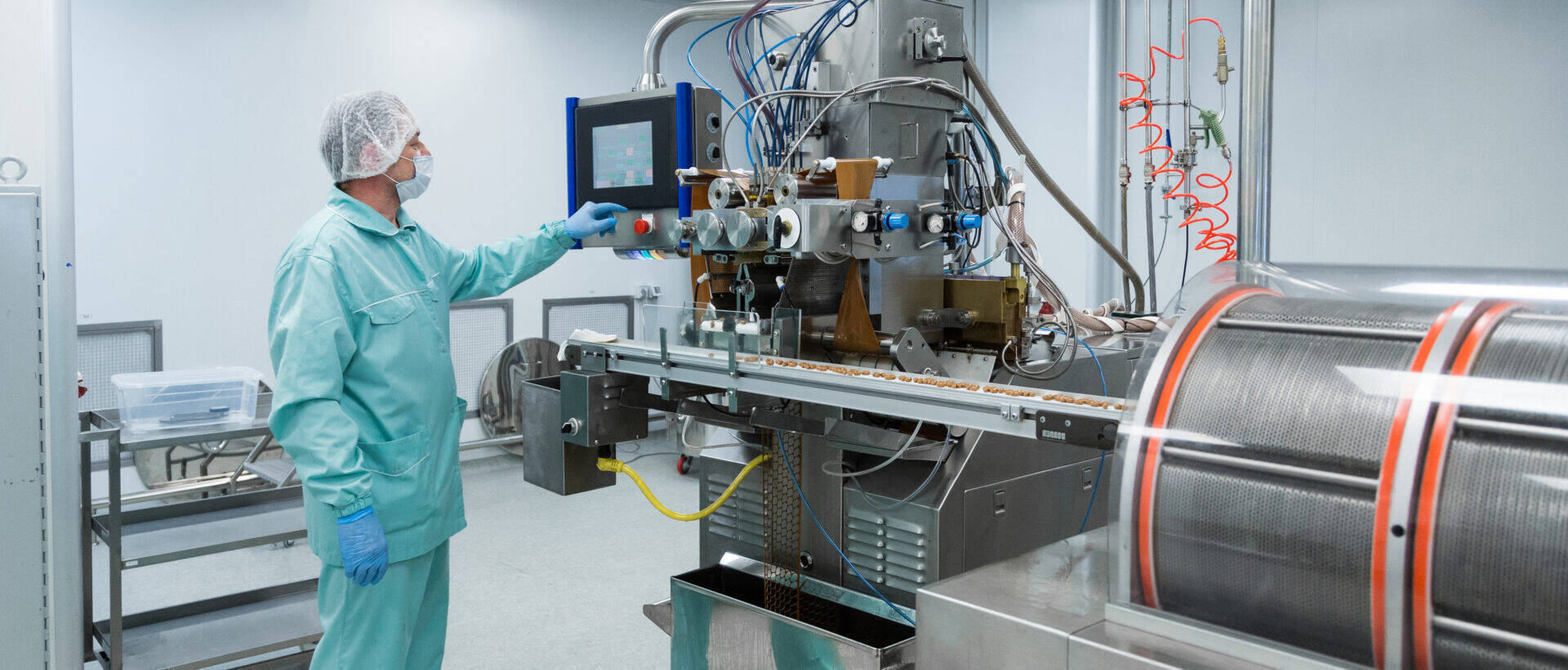

L’IA de 2026 ne sera probablement pas une intelligence générale. Elle sera mieux que cela pour les organisations : une infrastructure d’intelligence augmentée, intégrée aux processus réels, consciente de ses limites, conçue pour être contrôlée plutôt que spectaculaire.

Les modèles de langage resteront centraux, mais comme briques, pas comme fondations. Les systèmes agentiques progresseront, mais sous supervision. Les world models, la prédiction et l’anticipation retrouveront une place stratégique. L’infrastructure, calcul, énergie, données, gouvernance, deviendra un enjeu aussi important que les algorithmes eux-mêmes.

La question ne sera plus “qui gagne la course à l’IA”, mais :

- où se situent les leviers d’action réels,

- quels degrés de dépendance sont acceptables,

- quelles capacités internes doivent être conservées,

- et comment bâtir des systèmes capables d’évoluer sans se verrouiller.

Conclusion : l’IA devient adulte

L’année 2026 marque moins une rupture technologique qu’un changement de maturité. L’IA cesse d’être une promesse abstraite ou un récit messianique. Elle devient un objet d’ingénierie, de stratégie et de gouvernance.

Moins magique, mais plus utile.

C’est celle dont les entreprises, les États et les sociétés ont réellement besoin.

Partagez l'article